网络防火墙和病毒防火墙的差别

防火墙(Firewall)一词,在网络术语中是指一种软件,它可以在用户计算机和Internet之间建立起一道屏障(Wall),把用户和网络隔离开来;

如今,得益于低成本和大容量的存储设备,我们拥有了远多于以往的数据。不论有多少炒作的成分,我们还是要感谢大数据。但是,真正的 MVP 应该是更快和更好的计算能力,正因为有了这样的计算能力,我们才可以把二十世纪八九十年代的论文真正应用到实际中去(LSTM实际上是在 1997 年被发明的)。随着更快更好的 CPU(中央处理器)和 GPU(图形处理器)的出现,我们也终于能够发挥出神经网络和深度学习的真正力量。承认与否,在处理那些高维度、非结构化数据、高复杂度和大容量数据的问题时,传统的统计学和机器学习模型事实上具有严重的局限性。

深度学习已经开始在这些领域崭露头角,我们也看到它逐步被应用到一些现实世界中的规模化问题上。著名的人工智能传奇人物吴恩达在几年前也提到过相同的问题!

深度学习的优势在于,在构建解决方案时,我们拥有更好的计算能力、更多的数据,以及各种各样易于使用的开源框架,例如Keras、Tensorflow以及Pytorch等。

深度学习的劣势在于,从零开始建立自己的深度学习环境是一个非常痛苦的过程,尤其是在我们要迫切编写代码和实现深度学习模型的时候。

本文则是在作者多次实战部署的基础上,借助已有服务,尽可能避免从零创建深度学习环境,从而让你可以专注于快速构建学习模型,更快地解决问题。本文主要包括以下方面:直截了当,让我们开始吧!

首先您需要创建一个云的GPU云服务器,然后就可以开始您的表演了……

配置你的深度学习环境

我们接下来将要对你的基于 GPU 的深度学习环境进行必要的配置。如果你的虚拟服务器实例已经配置好 CUDA(Compute Unified Device Architecture- 通用计算设备架构)和 cuDNN(CUDA Deep Neural Network library- 深度神经网络加速库),那你可以根据需要跳过下面的一些步骤。

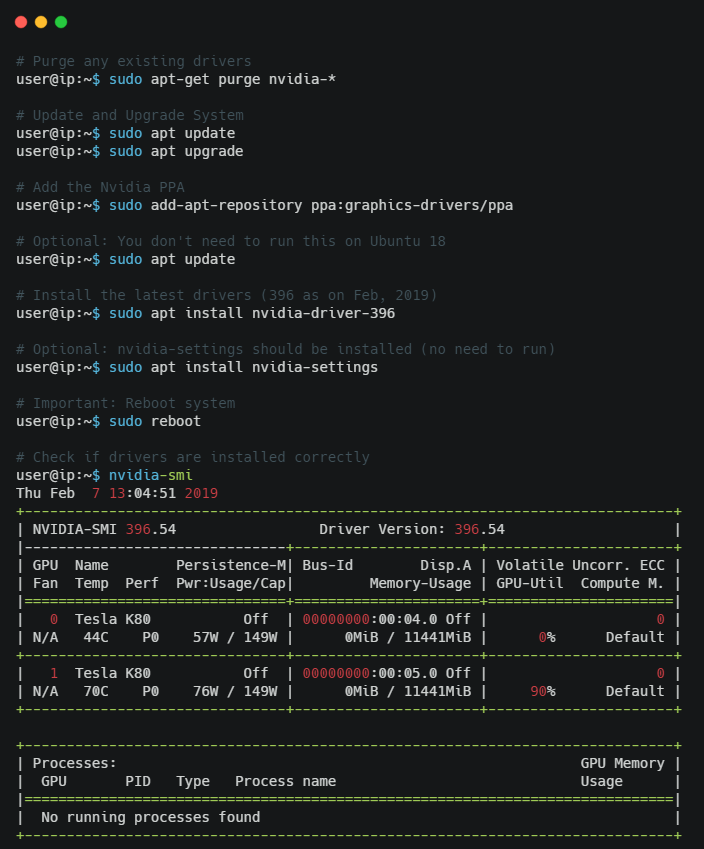

1. 安装图形驱动程序

首先确保 GPU 安装了相应的图形驱动程序。对于 NVIDIA 的 GPU,我们可以通过 nvidia-smi 命令进行驱动程序安装验证,如果该命令显示无法找到,则表明系统没有安装 GPU 驱动程序,正常输出如下图所示:

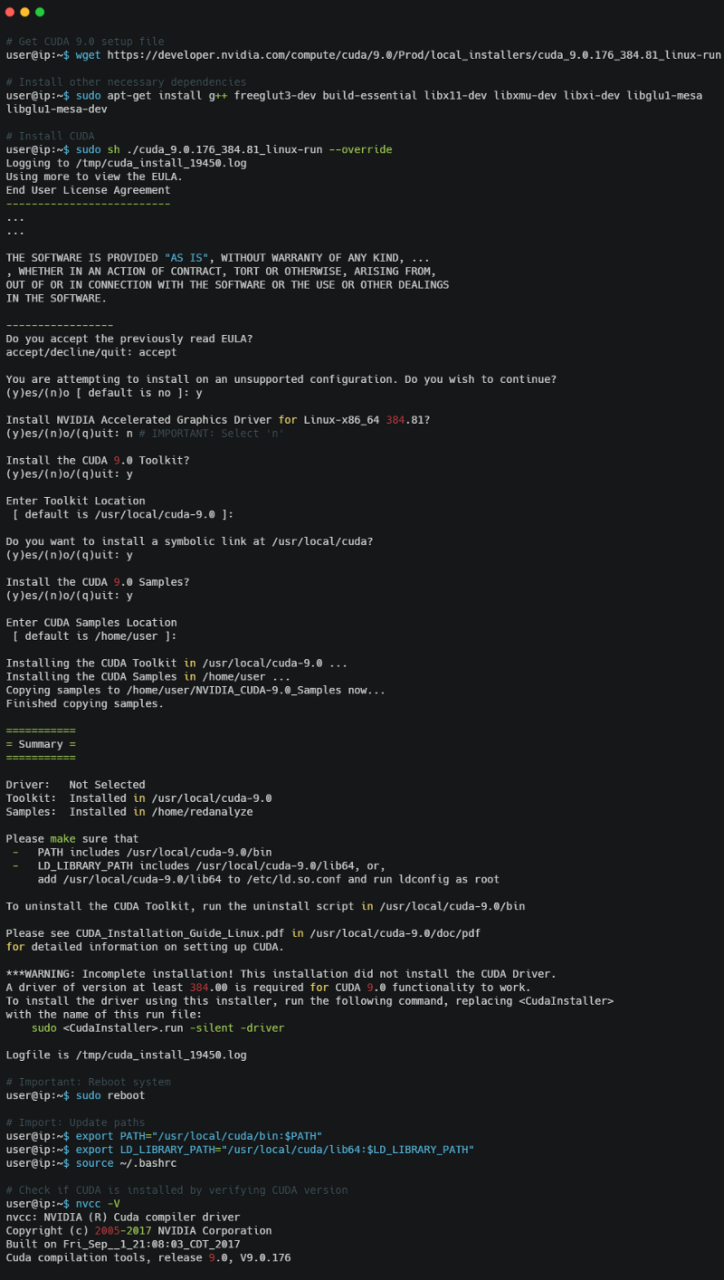

2. 安装 CUDA

Nvidia 的 CUDA 工具包基本上是一个开发环境,它能够最大限度地利用 NVIDIA GPU。CUDA 加速库可以让你在不改动代码的前提下直接应用到多个领域:线性代数、图像和视频处理、深度学习和图形分析等。假设我们使用 Ubuntu 的系统,你可以进入官方的 NVIDIA CUDA 页面并下载必要的安装文件。在写本文的时候,因为 CUDA 10 刚刚发布,我们因此使用了老版本的 CUDA 9.0,你可以从历史版本页面下载。如果你是在一个远程服务器上运行,可参照下图,使用终端直接下载安装文件并配置。

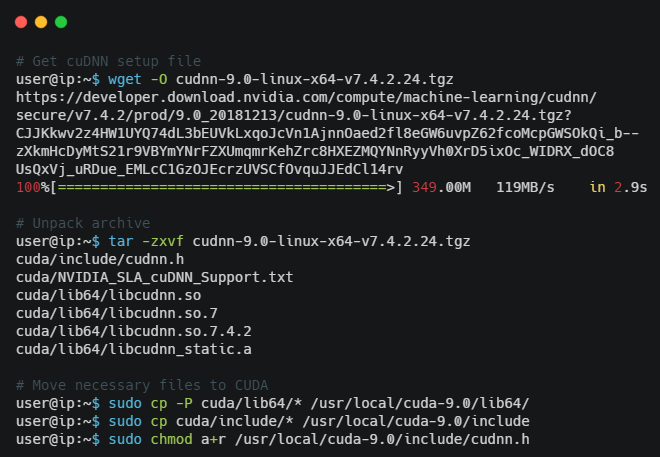

3. 安装 cuDNN

cuDNN 是一个针对深度神经网络的 GPU 加速类库。cuDNN 库为神经网络中的标准例程提供了一个高度调优的实现,包括前向和后向卷积、池化层、归一化和激活函数层。深度学习从业者可以完全依靠 cuDNN,它极大地加速了使用 GPU 的深度学习框架。你可以从官方页面下载,但首先要注册一个 NVIDIA 帐户。你可以得到一个 cuDNN 的下载链接,然后就可以在远程服务器终端上直接下载。

到这里,我们就完成了所有与 GPU 相关的设置。

4. 安装深度学习框架

现在,我们需要安装和设置基于 Python 的深度学习框架。我们通常使用 Keras 或 Tensorflow 框架,下面的命令可以帮助我们在环境中安装这些框架。

访问你的深度学习云环境

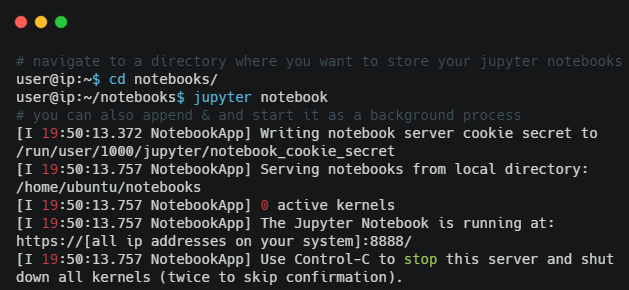

没有人想直接使用服务器的终端编写代码,使用 Jupyter Notebook 进行交互式开发显然是一个更好的选择。为此,我们需要通过本地系统访问云服务器上的 Notebook。当然,我们首先要在远程实例上启动 Jupyter Notebook 服务器。

现在,如果你已经为实例分配了一个公共 IP,并且绑定了公共端口 8888,那你可以直接在本地浏览器上通过地址http://IP 地址:8888访问云虚拟机中的 Jupyter 服务器!

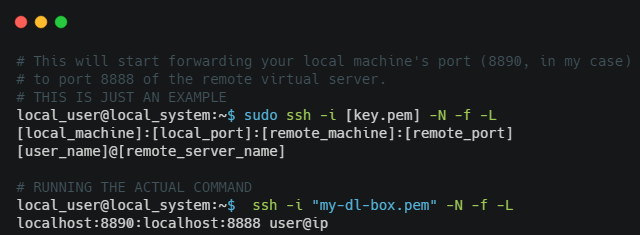

另一种选择则是使用 SSH 隧道,即在本地实例上启用端口转发,从本地浏览器直接访问云端的 Notebook,这对 AWS 实例尤其有用。

使用端口转发时,转到本地浏览器并输入到一个本地地址,例如,https://localhost:8890,浏览器将会导航到云虚拟机中的 Notebook 服务器。确保地址中使用了https,否则你将得到一个 SSL 错误。

验证 GPU 支持

最后一步为验证过程,确保我们的深度学习框架正在利用 GPU(通常按小时收费)。以下代码可以帮助我们验证。

看来我们的环境已经使用 GPU 进行深度学习了!

搭建本地开发环境建议

很多时候,用户或组织可能并不希望使用云服务,尤其是当他们的数据非常敏感的时候,因此他们需要构建一个基于本地的深度学习环境。这里的重点是选择正确的硬件和软件类型,利用合适的 GPU 来建立深度学习模型,实现资源利用的最大化。关于硬件选择,特别强调以下几点:

处理器:你可以使用一个英特尔的 i5 或 i7 处理器,或者至强系列,如果你不在乎价格的话!

内存:至少使用 32GB 的 DDR4、DDR5 或更好的内存。

磁盘:一个 1TB 的硬盘,而且你可以使用至少 128GB 或 256GB 的固态硬盘来加速数据访问!

GPU:深度学习最重要的组成部分。购买一个至少高于 GTX1070 显存 8GB 的 NVIDIA 图形处理单元。

其他需要注意的东西还包括主板、电源供应、坚固的外壳,以及冷却器。一旦组装好机器,我们就可以重复上一节中的所有步骤完成软件配置,然后开始深度学习了!